12月7日凌晨,谷歌(Google)在发布多模态大模型Gemini的同时,还推出了全新的面向云端AI加速的TPU v5p ,这也是谷歌迄今为止功能最强大且最具成本效益的 TPU(云张量处理单元)。

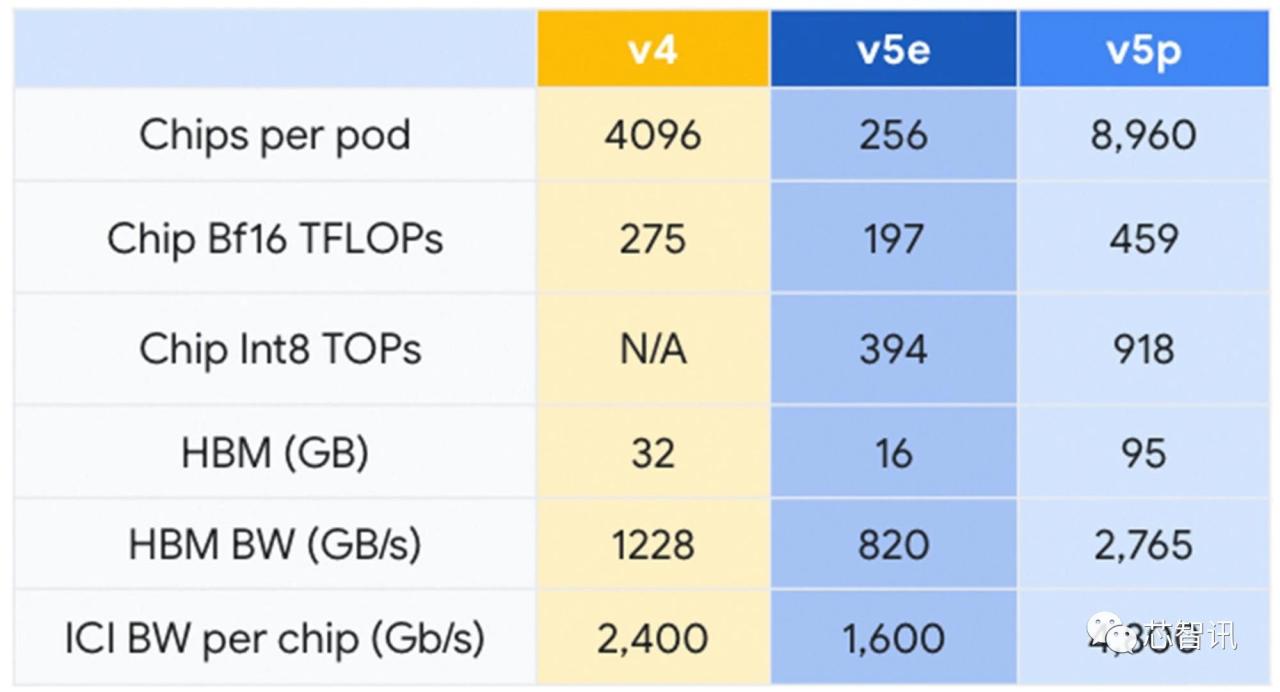

据介绍,每个 TPU v5p Pod 由多达 8,960 个芯片组成,使用最高带宽的芯片间连接(每芯片 4,800 Gbps)进行互连,确保快速传输速度和最佳性能。

在AI性能方面,TPU v5p能够提供459 teraFLOPS(每秒可执行459万亿次浮点运算)的bfloat16(16位浮点数格式)性能或918 teraOPS(每秒可执行918万亿次整数运算)的Int8(执行8位整数)性能,支持95GB的高带宽内存,能够以2.76 TB/s的速度传输数据。

与TPU v4相比,新发布的TPU v5p具有两倍的FLOPS(每秒浮点运算)和三倍的高内存带宽提升,这在人工智能领域是令人惊叹的。

此外,在模型训练方面,TPU v5p 在 LLM(大语言模型)训练速度上显示出 2.8 倍的代际提升,即使相比TPU v5e也有约50%的提升。Google还挤出更多的计算能力,因为 TPU v5p“就每个 Pod 的总可用 FLOP 而言,可扩展性比 TPU v4 高 4 倍”。

总结来说,TPU v5p与 TPU v4 相比:

- 浮点运算次数增加了 2 倍(459 TFLOPs Bf16 / 918 TOPs INT8)

- 内存容量比 TPU v4 (95 GB HBM) 高出 3 倍

- LLM 培训速度提高 2.8 倍

- 嵌入密集模型训练速度提高 1.9 倍

- 带宽增加 2.25 倍(2765 GB/秒 vs 1228 GB/秒)

- 芯片间互连带宽是原来的 2 倍(4800 Gbps 与 2400 Gbps)

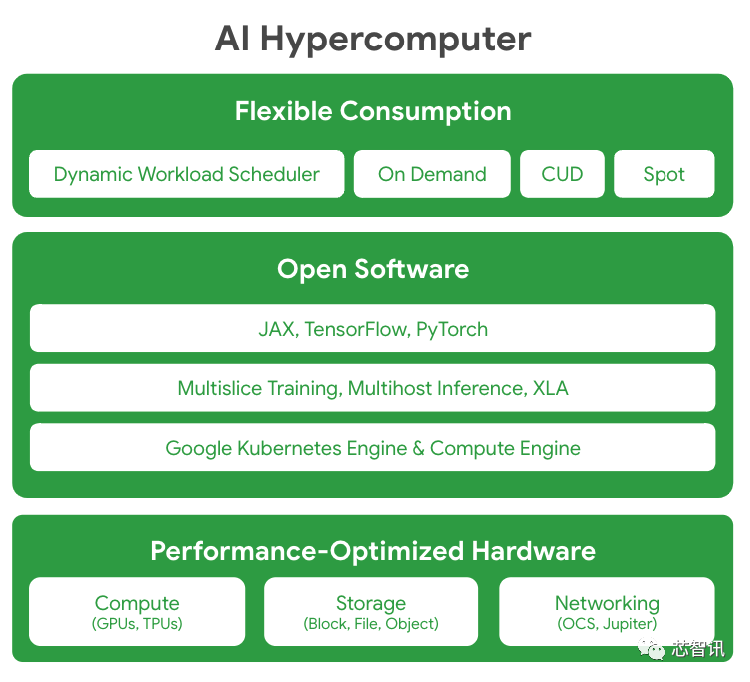

谷歌已经认识到在拥有最好的硬件和软件资源方面取得了明显的成功,这就是该公司拥有人工智能超级计算机的原因,它是一组旨在协作工作以实现现代人工智能工作负载的元素。谷歌集成了性能优化计算、最佳存储和液体冷却等功能,以充分利用巨大的功能,输出的性能确实是行业领先。

在软件方面,Google已经加强了使用开放软件来调整其人工智能工作负载,以确保其硬件的最佳性能。

以下是AI Hypercomputer新增软件资源的概要:

对流行的 ML 框架(例如 JAX、TensorFlow 和 PyTorch)的广泛支持开箱即用。JAX 和 PyTorch 均由 OpenXLA 编译器提供支持,用于构建复杂的 LLM。XLA 充当基础骨干,支持创建复杂的多层模型(使用 PyTorch/XLA 在云 TPU 上进行 Llama 2 训练和推理)。它优化了各种硬件平台上的分布式架构,确保针对不同的 AI 使用案例进行易于使用且高效的模型开发(AssemblyAI 利用 JAX/XLA 和 Cloud TPU 进行大规模 AI 语音)。

开放且独特的多片训练和多主机推理软件分别使扩展、训练和服务工作负载变得顺利和简单。开发人员可以扩展到数万个芯片来支持要求苛刻的人工智能工作负载。

与 Google Kubernetes Engine (GKE) 和 Google Compute Engine 深度集成,提供高效的资源管理、一致的操作环境、自动扩展、节点池自动配置、自动检查点、自动恢复和及时的故障恢复。

Google的人工智能革命性方法通过其新的硬件和软件元素显而易见,这些元素都将打破限制该行业的障碍。看看新的 Cloud TPU v5p 处理单元如何与 AI 超计算机一起帮助正在进行的AI开发将会很有趣,但有一点是肯定的,它们肯定会加剧竞争。

编辑:芯智讯-浪客剑