1月23日消息,据外媒报道,处理器大厂AMD最近开始量产出货其最新一代人工智能(AI)和高性能计算(HPC)加速器Instinct MI300X,并率先交付给了合作伙伴LaminiAI使用。LaminiAI将使用MI300X加速器执行其大型语言模型(LLM)的运算工作,以满足企业用户的需求。

据了解,LaminiAI与AMD已合作多年,因此优先获得MI300X的供货并不意外。LaminiAI CEO Sharon Zhou也在社交媒体上宣布了这一消息。他表示,LaminiAI已经收到了多台配备8个Instinct MI300X加速器的设备,首批AMD MI300X已经投入应用,LaminiAI的新一代LLM集群即将上线。

MI300X是AMD Instinct MI300系列的高性能版本,主打AI和HPC应用,是AMD与英伟达NVIDIA H100正面竞争的关键产品。

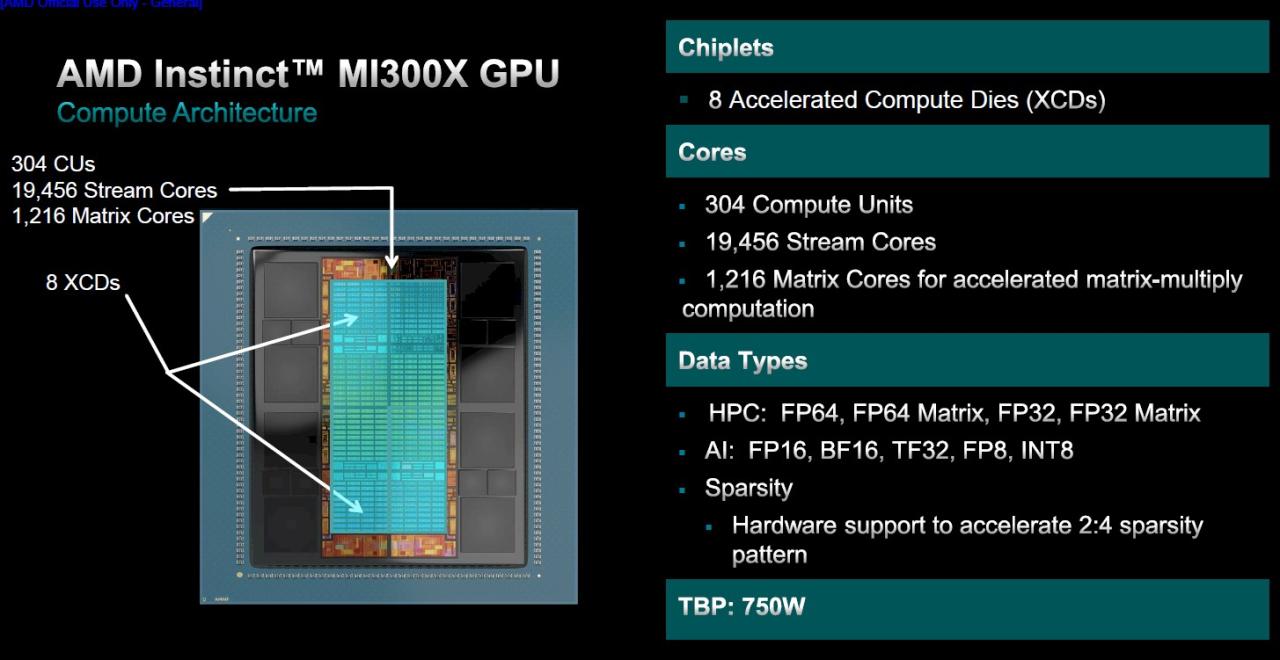

在硬件参数方面,MI300X内部集成了12个5/6nm工艺的小芯片(HMB和I/O为6nm),拥有1530亿个晶体管。在内核设计上,采用了相比MI250X更简单的设计,放弃了 APU 的 24 个Zen4内核和 I/O 芯片,取而代之的是更多计算核心的 CDNA 3 GPU。

MI300X的每个基于CDNA 3 GPU架构的XCD总共有八个计算芯片(XCD),每个计算芯片有40个计算单元,总共有320个计算单元,即20480个核心单元。不过,就目前的量产版而言,AMD缩减这些核心的一小部分,因此实际总共有304个计算单元(每个GPU小芯片38个CU)可用于19456个流处理器。

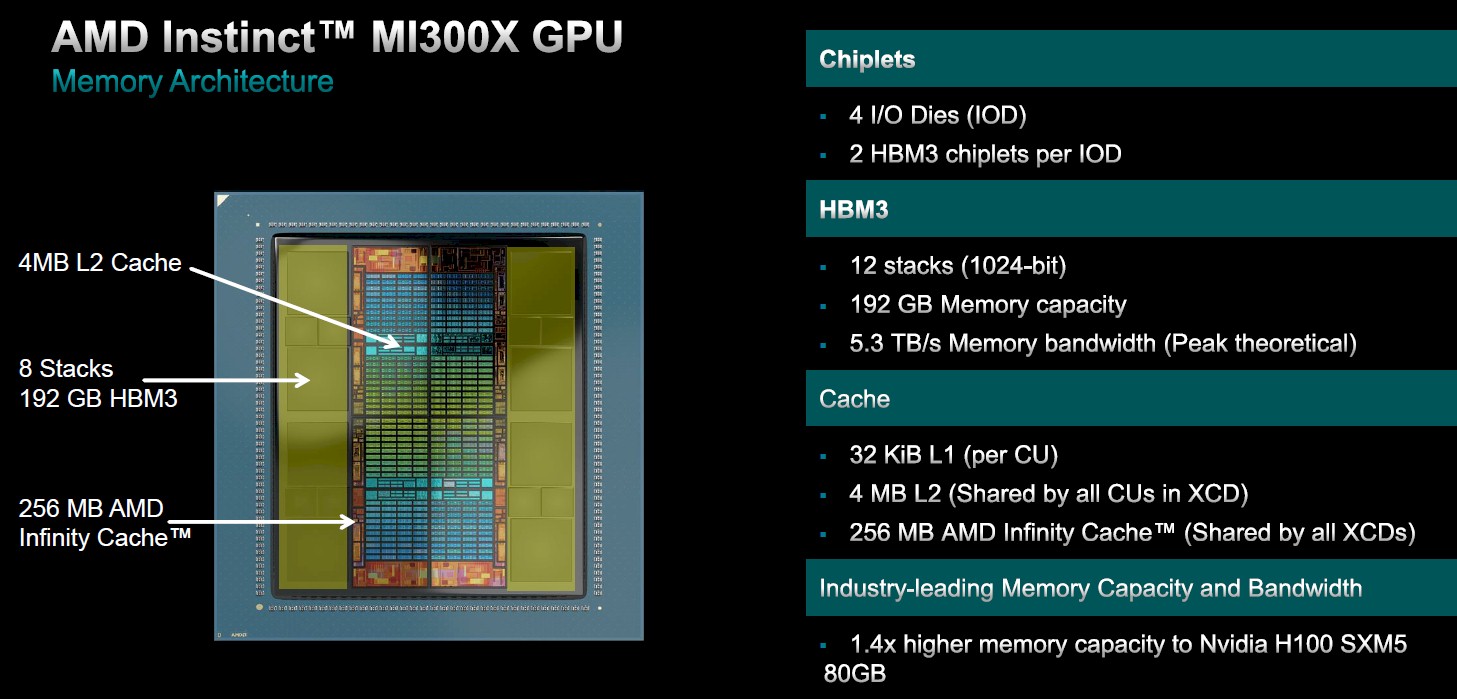

在内存带宽方面,MI300X也配备了更大的 192GB HBM3内存(8个HBM3封装,每个堆栈为12 Hi)相比MI250X提高了50%,带来最高5.3TB/s的带宽和896GB/s的Infinity Fabric带宽。相比之下,英伟达即将推出的H200 AI加速器提供141 GB的容量,而英特尔即将推出的Gaudi 3将提供144 GB的容量。大型内存池在LLM(大语言模型)中非常重要,LLM大多是与内存绑定的,AMD可以通过在HBM内存容量上的领先地位来提升器人工智能能力。

根据AMD官方的说法,MI300X与英伟达的H100加速器相比:

- 内存容量提高 2.4 倍

- 内存带宽提高 1.6 倍

- 1.3 倍 FP8 TFLOPS

- 1.3 倍 FP16 TFLOPS

- 在 1v1 比较中,速度比 H100 (Llama 2 70B) 快达 20%

- 在 1v1 比较中,速度比 H100 (FlashAttention 2) 快达 20%

- 8v8 服务器中的速度比 H100 (Llama 2 70B) 快达 40%

- 在 8v8 服务器中,速度比 H100 (Bloom 176B) 快达 60%

目前,Meta、微软等巨头客户已采购了大量AMD Instinct MI300系列产品,LaminiAI则是首家公开使用MI300X的公司。

编辑:芯智讯-浪客剑