6月4日,英特尔CEO帕特·基辛格在COMPUTEX 2024上发表主题演讲,其回顾了英特尔与中国台湾产业界的合作,分享了对于半导体及AI未来发展的看法,并介绍了英特尔Xeon 6处理器、Gaudi 3加速器的进展,并正式公布了下一代面向AI PC的移动处理器Lunar Lake。

基辛格:摩尔定律依然有效

基辛格表示,首届COMPUTEX于1981年举办,当时英特尔正努力开发芯片,并于次年推出了80286微处理器,当时晶体管数量仅数十万,现在已经暴增到了上千亿个,而中国台湾一直半导体产业当中扮演核心角色。英特尔于1985年进入中国台湾,与当地的合作伙伴合作已有长达近40年的时间。

对于科技产业未来的发展,基辛格强调,摩尔定律依然有效,单位面积的晶体管数量仍将持续增加。即便是在AI时代,英特尔处理器不但不会失去动力,反而会继续发挥重要作用。

“摩尔定律依然有效,我认为它就像25年前的互联网,规模和潜力庞大。我们相信,这是推动半导体行业在2030年之前达到单芯片集成1万亿颗晶体管的动力。”基辛格坚定的说道。

基辛格进一步指出,AI正在改变世界,未来AI也将无所不在,不断扩展边界至人们各种体验,包括AI PC、边缘计算以及数据中心,这也意味着对处理器的性能、服务器容量、电力、能源等会有越来越多的需求。

Xeon 6 E-core

对此,英特尔在今年4月的“Intel Vision 2024”大会,发布了第六代至强(Xeon)可扩展处理器以及新一代的云端AI加速芯片Gaudi 3。

英特尔 Xeon 6处理器,这也是首款基于Intel 3制程服务器芯片,拥有基于性能核(P-core)的 Xeon 6(此前代号为Granite Rapids)和基于能效核(E-core)的 Xeon 6(此前代号为Sierra Forest)两个系列。其中,率先上市的将是Xeon 6 E-cores处理器,具有144 核和 288 核的两种配置,相比第二代英特尔 Xeon 处理器,媒体转译性能上改善了4.2倍,每瓦性能提高了 2.6 倍,并且机架密度提高了 2.7 倍,可节省8,000兆瓦时(MWh)电力。

Gaudi 3已经上市

至于Gaudi 3,采用的是台积电5nm工艺,拥有 8 个矩阵数学引擎、64 个张量内核、96MB SRAM(每个Tile 48MB,可提供12.8 TB/s的总带宽) 和 128 GB HBM2e 内存,16 个 PCIe 5.0 通道和 24 个 200GbE 链路 。在计算核心的周围,则是八个HBM2e内存堆栈,总容量为128 GB,带宽为3.7 TBps。

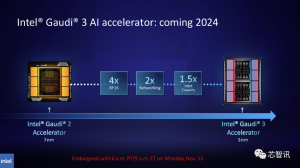

与上一代的Gaudi 2 相比,Gaudi 3在BF16工作负载方面的性能将是Gaudi 2的四倍,FP8性能也将是Gaudi 2 的两倍,网络性能也是Gaudi 2的两倍(Gaudi 2是24个内置的100 GbE RoCE Nic),HBM容量是Gaudi 2的1.5倍。

根据英特尔官方公布的数据显示,Gaudi 3 在流行的大语言模型(LLM)训练速度方面,比英伟达H100平均快了40%;在流行大模型的推理能效表现上,比如英伟达H100领先50%。英特尔 Gaudi 3 与英伟达 H100 在相同节点数量下,相关大模型训练时间对比上最高快了1.7倍,其中,LLAMA2 70 亿参数对比有 1.5 倍于 H100 的优势,LLAMA2 130 亿参数最高有 1.7 倍的优势,GPT-3 1750 亿参数有 1.4 倍优势。在大模型推理速度表现上,Gaudi 3 相比 H100 平均快了1.5倍,最高快了4倍。

据英特尔介绍,目前Gaudi 3已经上市,除了与戴尔、慧与科技、联想和美超威合作外,今天还宣布与华硕、鸿海、技嘉、英业达、广达和纬创展开合作,扩大产品线布局。

英特尔表示,Xeon处理器与Gaudi系列加速器不仅具备高效能,整体成本低于其他平台的三分之一,这两款产品也可以整合在单一系统中,整体平台也比其他竞争者的解决方案更具竞争力。

Intel全新AI PC芯片Lunar Lake发布

在此次的COMPUTEX 2024展会上,英特尔还发布了下一代AI PC芯片Lunar Lake。不仅CPU、GPU、NPU性能全面提升,能耗也大幅降低,综合AI算力提升至120TOPS。

1、Lunar Lake首次全部由台积电代工,但下一代的Panther lake将重回英特尔代工

据介绍Lunar Lake由7个主要部分组成,整个封装包含内存、加固器和底层芯片,底层芯片使用Intel Foveros互连技术将计算芯片和平台控制器芯片结合在一起。在工艺节点方面,Lunar Lake计算芯片(包括CPU、GPU和NPU等)采用台积电的N3B工艺节点制造,平台控制器芯片则采用台积电的N6工艺节点制造,也就是说这款芯片的主要核心die全部都是由台积电代工!

要知到之前英特尔的高端移动平台芯片虽然有部分核心是交由台积电代工,但是CPU核心一直是英特尔自己生产的。而这种转变,一方面是台积电在制程技术上的领先,另一方面则可能与英特尔代工业务独立分拆有关。英特尔代工业务独立分拆,使得英特尔的设计业务可以更自由的选择外部更有竞争力的供应商,但是这对于英特尔代工业务集团来说并不是一个好消息,所幸的是Lunar Lake的封装还是交由英特尔代工业务集团来完成的。

对此,基辛格表示,Lunar Lake之所以选择台积电制造,是因为当时台积电有更好的制程技术,现在看仍是好选择。感谢台积电,提供了很多核心关键制造技术,使Lunar Lake成为可能,也能看出台积电和英特尔在代工产业的合作,包括UCIe(通用小芯片互连)也是。

不过基辛格强调,到下一代Panther lake将几乎全部是基于英特尔制程,将采用Intel 18A工艺,还有混合键合技术、晶圆对晶圆(Wafer to Wafer)堆叠,还有先进封装技术和背面供电技术,希望届时能够向大家展示英特尔的晶圆厂能力。

1、CPU核心:4个P核+4个E核,性能及效率大幅提升

据介绍,Lunar Lake的CPU内核依然采用的Hybrid核心架构设计,拥有4个Lion Cove P-core性能核心和4个Skymont E-core效率核心,组合成8核心混合设计,以达到性能与效率的最佳。

Lunar Lake的Lion Cove P-core性能核心在缓存层次上进行了众大改进,其采用了多层数据缓存,每个核心包括一个 48KB L0D 缓存(加载到使用延迟为 4 周期)、一个 192KB L1D 缓存(延迟为 9 周期)、一个扩展的 L2 缓存(最高可达 3MB,延迟为 17 周期)。总的来说,这使得 240KB 缓存的延迟时间与 CPU 内核的延迟时间相差无几,而之前的 Redwood Cove 只能在相同时间内达到 48KB 缓存。4个P核心还共享了12MB L3缓存,可以带来更出色的单线程性能,并优化核心PPA设计。

英特尔添加了第三个地址生成单元 (AGU)/存储单元对,以进一步提升存储性能。值得注意的是,这使加载和存储管道的数量达到平衡,分别为 3 个;在大多数英特尔架构中,加载单元的数量都比存储单元多。

总体而言,英特尔在真正的长期 CPU 设计理念中,已经投入了更多缓存来解决这个问题。随着 CPU 复杂度的增加,缓存子系统也在不断增加,以保证其正常运行。在这种情况下,保证 CPU 正常运行是提高其性能和保持其能效的关键改进。

深入研究 Lion Cove 的计算架构,该架构在英特尔的 P 核设计上专注于提高性能和效率。该架构采用一种新的前端方法来处理指令,其预测块比以前大 8 倍,提取范围更广,解码带宽更高,Uops 缓存容量和读取带宽也大幅增加。UOP 队列容量增加,这也提高了整体吞吐量。在执行过程中,Lion Cove 的无序引擎在整数 (INT) 和矢量 (VEC) 域之间划分,具有独立的重命名和调度功能。

数据转换后备缓冲区 (DTLB) 也进行了修改,将其深度从 96 页增加到 128 页,以提高其命中率。这种分区方式可以实现未来的可扩展性、每个域的独立增长,并且有利于降低特定域工作负载的功耗。乱序引擎也得到了改进,分配/重命名从 6 个增加到 8 个,退出从 8 个增加到 12 个,深度指令窗口从 512 个增加到 576 个,执行端口从 12 个增加到 18 个。这些变化使管道更加稳健,执行起来也更加灵活。

Lion Cove 中的整数执行单元也得到了改进:整数 ALU 从 5 个增加到 6 个,跳跃单元从 2 个增加到 3 个,移位单元从 2 个增加到 3 个。它们将64x64单元增加到超过64,并从 1 个单元增加到 3 个,为最复杂的操作提供更强大的计算能力。另一个显著的进步是 P 核心数据库从“sea of fubs”迁移到了 “sea of cells”。更新 P 核心子结构组织的过程从微小的、以锁存器为主的分区转变为更广泛、更大的以触发器为主的分区,这些分区在发展过程中非常不可知。

Lion Cove 架构也与性能提升保持一致,与上一代 Redwood Cove 相比,IPC 性能预计将提升两位数百分比。这种提升尤其明显,尤其是在超线程的改进方面,IPC 提高了 30%,动态功率效率提高了 20%,并且在不增加核心面积的情况下平衡了先前的技术,体现了英特尔在现有物理限制内提高性能的承诺。

Lion Cove 的电源管理也得到了改进,包括采用 AI 自调节控制器来取代静态热保护带。它让系统以自适应方式动态响应实际的实时运行条件,以实现更高的持续性能。它使用更精细的时钟粒度,现在间隔为 16.67MHz。与 100MHz 相比,这意味着更精确的电源管理和性能调整,从而从功率预算中获得最大效率。

至少从纸面上看,Lion Cove 看起来比 Golden Cove 有了很大的改进。它整合了改进的内存和缓存子系统、更好的电源管理以及 IPC 性能的提升,而不是专注于提高频率。

Lunar Lake的Skymont E-core效率核心是专为实现全新水平的性能效率而设计。Skymont 核心具有更全面的机器架构,首先是 9-wide 解码阶段,其解码簇比前几代多 50%。这由更大的微操作队列支持,现在可容纳 96 个条目,而旧设计中只有 64 个。使用“Nanocode”可在每个解码簇内增加更多微代码并行性。

Skymont核心的无序执行引擎也得到了显著改进。分配宽度增加到 8-wide,而退出阶段则加倍到 16-wide。这增强了内核同时发出和执行多条指令的能力,并通过依赖中断机制减少了延迟。

Skymont 将重排序缓冲区从之前的 256 个条目加深到 416 个条目,以提供排队和缓冲功能。此外,物理寄存器文件 (PRF) 和保留站的大小也增加了。这些增强功能使内核能够处理更多正在运行的指令,从而提高指令执行的并行性。

需要注意的是,调度端口最初为 26 个,其中 8 个用于整数 ALU,3 个用于跳转操作,3 个用于每个周期的加载操作,从而进一步实现了灵活高效的资源分配。在矢量性能方面,Skymont 支持 4×128 位 FP 和 SIMD 矢量,这使每秒千兆次浮点运算 (Gigaflops/TOPs) 翻倍,并降低了浮点运算的延迟。英特尔还重新设计了内存子系统,四个内核共享 4MB L2 缓存,将 L2 带宽翻倍至每周期 128B,在此过程中,降低了内存访问延迟,同时提高了数据吞吐量。

英特尔公布的性能指标,凸显了Skymont E核的电源效率的显著提升:与上代的Meteor Lake 的 LP E 核相比,单线程性能提高了 1.7 倍,而功耗仅为其三分之一。

当将 Skymont E-core 集群与 Meteor Lake的 LP E-core 集群直接进行比较时,多线程性能提高了 2.9 倍,而功耗却全面降低。

这对于移动和桌面设计同样有用。换句话说,Skymont E 核心非常灵活,在移动场景中充分利用了低功耗结构和系统缓存,并针对桌面计算块优化了多线程吞吐量。与 Raptor Cove 相比,Skymont在单线程工作负载中提供了 2% 更好的整数和浮点性能,其功率和热量范围几乎与其前代产品相同。

Skymont E 核代表了英特尔内核架构开发的下一步,在解码、执行、内存子系统和电源效率方面取得了显著的进步,满足了更节能计算的需求,并且比以前的 Crestmont E 核提高了 IPC 增益。

Xe2 GPU性能提升50%,还有全新显示、多媒体和图像引擎

Lunar Lake的GPU采用的是新一代的Xe2 GPU构架,拥有8组新一代Xe核心、8个光线追踪单元、XMX AI引擎和8MB的专属缓存。能够提供67 GPU TOPS的算力、实时的光线追踪、基于AI的XeSS画质提升、Intel Arc软件堆叠等功能,相比上一代Meteor Lake能带来50%的图形处理性能提升。

Lunar Lake内部还集成了与GPU搭配的全新显示、多媒体和图像引擎(IPU)。其中,显示核心拥有3个eDP 1.5、DP与HDMI 2.1输出接口,多媒体引擎支持AV1和最新的VVC编译功能,IPU则可提供Temporal noise reduction、Multi-frame与Dual exposure staggered HDR等图像强化功能。

具体来说,英特尔的 eDisplayPort 1.5 包含面板重放功能,该功能集成了自适应同步和选择性更新机制。这有助于通过仅刷新屏幕发生变化的部分而不是整个显示屏来降低功耗。这些创新不仅节省能源,而且还通过减少显示延迟和提高同步精度来改善视觉体验。

描绘像素处理管道是英特尔显示引擎所依赖的基本基础之一,每条管道支持六个平面,用于高级颜色转换和合成。此外,它还集成了对颜色增强、显示缩放、像素调整和 HDR 感知量化的硬件支持,确保屏幕上的图形生动准确。该设计非常灵活,非常节能,性能经过精心设计,至少在纸面上支持各种输入和输出格式。到目前为止,英特尔尚未提供任何可量化的功率指标、TDP 或其他功率元素。

在压缩和编码方面,Xe2 架构可无损地将显示流压缩率提高到 3:1,包括针对 HDMI 和 DisplayPort 协议的传输编码。这些芯片功能可进一步降低数据负载,并在输出端保持高分辨率,而不会损失视觉质量。

多媒体引擎方面,英特尔采用 VVC 编解码器对视频压缩技术的改进意义重大。与 AV1 相比,此编解码器可将文件大小减少 10%,并支持自适应分辨率流媒体和针对 360 度和全景视频的高级内容编码。这将确保流媒体的比特率较低,而不会降低质量——这是现代多媒体应用的一个基本方面。

Windows GPU 软件堆栈从上到下都非常强大,支持 D3D、Vulkan 和 Intel VPL API 和框架。这意味着,结合这些品质可以为市场上各种运行时和驱动程序提供全面支持,从而提高其在不同软件环境中的整体效率和兼容性。

3、NPU算力提升至48TOPS

作为新一代面向笔记本电脑的AI PC处理器,Lunar Lake的神经处理单元(NPU)带来了重大升级,其集成了全新的第四代NPU内核(NPU 4),具备6个Neural Compute引擎、12个强化SHAVE 数字信号处理器(DSP)与9MB缓存,能够提供48 TOPS的AI算力。

与上一代 NPU 3 相比,NPU 4 在增强神经处理能力和效率方面有了巨大飞跃。NPU 4 的改进主要是通过实现更高的频率、更好的电源架构和更多的引擎数量来实现的,从而赋予它更好的性能和效率。

在 NPU 4 中,这些改进在矢量性能架构中得到了增强,计算块数量更多,矩阵计算的优化性更好。这需要大量的神经处理带宽;换句话说,这对于需要超高速数据处理和实时推理的应用程序至关重要。

该架构支持 INT8 和 FP16 精度,INT8 每周期最多可进行 2048 次 MAC(乘法累加)运算,FP16 每周期最多可进行 1024 次 MAC 运算,这显然表明计算效率显著提高。

更深入地了解架构后,可以发现 NPU 4 的层次有所增加。其每个神经计算引擎都嵌入了令人难以置信的出色推理管道,包括 MAC 阵列和许多用于不同类型计算的专用 DSP。该管道专为众多并行操作而构建,从而提高了性能和效率。新的 SHAVE DSP 经过优化,矢量计算能力是上一代的四倍,可以处理更复杂的神经网络。

NPU 4 的另一项重大改进是提高了时钟速度,并引入了一个新节点,在与 NPU 3 相同的功率水平下将性能提高了一倍。这使峰值性能提高了四倍,使 NPU 4 成为要求苛刻的 AI 应用的强大引擎。新的 MAC 阵列在芯片上具有先进的数据转换功能,允许动态进行数据类型转换、融合操作和输出数据布局,从而使数据流以最小的延迟达到最佳状态。

NPU 4 的带宽改进对于处理更大的模型和数据集至关重要,尤其是在基于 Transformer 语言模型的应用程序中。该架构支持更高的数据流,从而减少瓶颈并确保即使在运行时也能顺利运行。NPU 4 的 DMA(直接内存访问)引擎将 DMA 带宽翻倍——这是提高网络性能的重要补充,也是处理重型神经网络模型的有效方法。进一步支持更多功能,包括嵌入标记化,从而扩大了 NPU 4 的潜力。

NPU 4 的另一项显著改进在于矩阵乘法和卷积运算,其中 MAC 阵列可以在单个周期内处理最多 2048 个 MAC 运算(INT8)和 1024 个 MAC 运算(FP16)。这反过来又使得 NPU 能够以更高的速度和更低的功率处理更复杂的神经网络计算。这在矢量寄存器文件的维度上产生了差异;NPU 4 的宽度为 512 位。这意味着在一个时钟周期内,可以进行更多的矢量运算;这反过来又提高了计算效率。

NPU 4 支持激活函数,现在有更多种类的激活函数可以支持和处理任何神经网络,并可选择精度来支持浮点计算,这将使计算更加精确和可靠。改进的激活函数和优化的推理管道,将使其能够以更快的速度和更高的准确度执行更复杂和更细致的神经网络模型。

NPU 4 中的 SHAVE DSP 升级,使得其矢量计算能力达到了 NPU 3 的四倍,将整体的矢量性能整体提高 12 倍。这对于转换器和大型语言模型 (LLM) 性能非常有用,使其更加快速和节能。增加每个时钟周期的矢量操作可以实现更大的矢量寄存器文件大小,从而显著提升 NPU 4 的计算能力。

总体而言,NPU 4 的性能比 NPU 3 有了大幅提升,整体的矢量性能提高了 12 倍,TOPS 算力提高了 4 倍,IP 带宽提高了 2 倍。这些改进使 NPU 4 成为高性能和高效率的AI解决方案,适合性能和延迟至关重要的最新 AI 和机器学习应用。这些架构改进以及数据转换和带宽改进使 NPU 4 成为管理要求极高的 AI 工作负载的顶级解决方案。

4、更好的安全技术和高速连接技术

Lunar Lake平台的控制层还内置了安全和新一代高速连接技术。

在安全方面,拥有Intel Partner Security(合作伙伴安全)引擎、Intel Silicon Security(硅安全)引擎、Converged Security和Manageability(融合安全与可管理性)引擎。

连接方面,Lunar Lake平台则整合了最新的Wi-Fi 7、Bluetooth 5.4与1GbE MAC连接技术。

其中,集成的Wi-Fi 7解决方案支持多链路操作(Multi-Link Operation或MLO),它增加了可靠性,提高了吞吐量(支持5.8Gbps),改善了延迟,并实现了流量分离/区分。与BE200网络接口相比,硅片尺寸缩小了28%,并采用11Gbps的CNVio3接口。此外,还采用了射频干扰缓解技术,可动态调整对Wi-Fi性能有重大影响的DDR时钟频率。

英特尔还宣布与Meta 的合作更进一步,利用这项 Wi-Fi 7 技术来增强 VR 体验。这进一步优化了视频延迟性能并减少了干扰,从而使 VR 应用更加无缝和引人入胜,至少从无线连接的角度来看是如此。Wi-Fi 7 的新增强功能提供了高、可靠的速度和低延迟,可满足 VR 应用中最具挑战性的需求。

在接口方面,Lunar Lake提供4个PCIe 5.0、4个PCIe 4.0、3个整合的Thunderbolt 4(40Gbps)、2个USB 3.0与6个USB 2.0等接口。值得一提的是,Thunderbolt 4 接口通过Thunderbolt Share加速,可以将生产力提升到一个新水平,实现多台电脑连接。

5、3D Foveros封装与Scalable Fabric Gen 2互联

Lunar Lake以上所有的计算核心、Memory Side缓存、安全、连接和I/O模块均通过英特尔的3D Foveros多芯片封装技术共同封装在处理器基板上,并采用Memory On Package封装,在Lunar Lake核心的旁边封装了32GB內存。

需要指出的是Lunar Lake的32GB w/ 2 Ranks LPDDR5X內存颗粒与处理器一同封装在基版上,每芯片可有着8.5GT/s的传输频宽、支持16b x 4信道,能够降低40% PHY电源并节省250mm²的电路版面积。

Lunar Lake的CPU、GPU和NPU计算核心则通过Scalable Fabric Gen 2进行互联,然后通过D2D直接与平台控制层的Scalable Fabric Gen 2连接,能够无缝的衔接计算节点、芯片层,让计算核心能有着更好的扩展性与效率。此外,借助Home Agent统筹整个层级的一致性(Hierarchical Coherency),包括Memory Side缓存、每个核心丛集中的Coherency Agent,包括平台控制层的I/O Coherency。

6、全新的供电设计与电源管理,综合能耗可降低40%

在供电方面,Lunar Lake采用了新的4个PMIC供电设计,可提供更多的供电路径、动态电压ID与更多的监控功能。针对SoC的供电使用优化达到最佳的性能效率。

在电源管理方面,集成的英特尔线程控制器专注于效率,还有针对每种负载类型优化的功率平衡器,增强的“睡眠”状态电源和延迟,以及基于ML的WL分类与频率控制。Thread Director(线程调度器)通过识别每个工作负载的级别并使用其能源和性能内核评分机制,帮助操作系统将线程调度到性能和效率最佳的内核上。

另外,Lunar Lake还在众多核心芯片中加入了共享的8MB Memory Side缓存,可以降低DRAM的传输次数并节省电源,借助缓存机制让核心与DRAM间的延迟进一步降低并提升传输带宽。

根据英特尔公布的数据显示,得益于先进的工艺节点、新的E-core设计、Memory Side缓存、供电设计、电源管理及线程调度器技术,Lunar Lake比起上一代的Meteor Lake 的能耗可降低40%。

Lunar Lake三季度出货,Arrow Lake四季度推出

据介绍,目前Lunar Lake已有超过80款设计,来自20家OEM厂商,预计第三季开始出货。

英特尔还透露了未来的面向AI PC的移动处理器构架,今年第四季将推出面向桌面端的Arrow Lake,明年将会推出采用Intel 18A的Panther Lake,2026年后还会有后续新产品。

小结:综合AI算力高达120 TOPS

从Lunar Lake的内部的各个核心来看,相对于上代的Meteor Lake,无疑是带来了重大的升级,不仅CPU核心将 Lion Cove P 核与 Skymont E 核集成在一起,还带了最新的 Xe2-LPG GPU架构,以及新一代的NPU 4 内核,带来了领先的AI性能。

结合CPU、GPU和NPU所提供的AI算力,使得整个Lunar Lake平台的AI总算力达到了120 TOPS,凸显了英特尔在 AI 方面的投资。其中,CPU可通过VNNI与AVX指令提供5 TOPS的算力,驱动轻度AI工作;GPU提供的67 TOPS算力则通过XMX与DP4a提供游戏与创作所需的AI性能;NPU提供的48 TOPS算力能够处理密集向量与矩阵运算,提供AI辅助与创作等功能。

作为对比,高通骁龙X Elite的NPU的算力为45TOPS,苹果M4的NPU的算力只有38TOPS,虽然AMD最新推出的AI PC芯片——锐龙AI 300系列集成的AMD第三代NPU内核的AI算力提升到50TOPS,英特尔Lunar Lake的NPU内核的AI算力48TOPS略低,但是依然是大幅超过了微软对于Copilot+ PC的最低NPU算力40TOPS的需求门槛,并且英特尔更专注于提供更高的综合的AI算力,即通过AI引擎结合NPU、CPU和GPU,将综合AI算力提高到了120TOPS,达到了上代Meteor Lake的接近3倍,这样的提升幅度不可谓不高。

特别值得一提的是,Lunar Lake 还带来了供电和电源管理方面的大幅改进,结合更先进的工艺节点、CPU计算核心等在能效方面的改进,使得Lunar Lake比起上一代的Meteor Lake 的能耗大幅降低,更适合于移动设备。

根据英特尔披露的数据显示,Lunar Lake的GPU性能提升50%、NPU内核的AI算力增加了四倍、SoC耗电量减少40%、GPU AI算力增加3.5倍,整个SoC的算力超过了120TOPS。

总结来说,Lunar Lake相比上代的Meteor Lake带来了巨大的性能提升,特别是在AI能力方面,同时也带来了更高的能效和更低的功耗。相对于其他的AI PC芯片竞品来说,依然有着不小的优势。

英特尔CEO基辛格在演讲当中也表示,非常看好AI PC的发展,目前已有超过800万台搭载英特尔—Core Ultra处理器的AI PC出货,显示AI PC时代已然来临。

同时基辛格还预计今年基于英特尔芯片的AI PC出货将达到4500万台,在2028年时,搭载AI功能的PC在所有PC当中的占比将达到80%的水平。而英特尔拥有300多个AI加速功能、500多个人工智能模型,当AI PC进入市场时,英特尔已经拥有了完整的AI PC生态系统。

显然,随着Lunar Lake的推出,将有助于进一步增强英特尔在AI PC芯片市场的竞争力。不过,Lunar Lake的具体市场表现如何,还有待观察。

谈到高通等Windows on Arm设备推出是否会影响英特尔X86 PC芯片的市占率,基辛格认为,这不是第一个Windows on Arm的产品发布,x86市占率仍维持领先,目前还没明确诱因促使消费者从x86平台转换到Arm平台,也还没看到类似产品能取代x86现有构架,认为消费者需要有改变的理由,加上新推出的Lunar Lake拥有更好的性能表现,并不怕市占受影响。

被问到是否视高通为对手?基辛格笑说欢迎高通推出自家产品进入市场,因为这有助于更快创造整个市场,不过对自己很有自信,目前出货量已经售100万台,从这角度看,表现比高通昨天呈现的Snapdragon X Elite更优秀。此外,从Lunar Lake到下一代Panther Lake,英特尔是打造自家生态系,是全新的篇章,在整个AI也很难被取代。

基辛格指出,下半年客户购买Lunar Lake的PC会相当好的体验,相信也会和高通产品做比较,未来会有更多跑分等信息出现。

目前英特尔积极扩展海外制造,在美国也有多项半导体建设。基辛格认为英特尔、三星、台积电在美国布局,显示美国芯片产业将有很大发展,研调机构也预期美国在半导体的影响力从10%增加至2030年的20%,相信会有很大动能的发展。英特尔在演讲中不断赞扬台积电在Lunar Lake及与联电的合作,显示重视中国台湾生态系,但全球需要更平衡的供应链,相信现在正在成形中。

对于被美国限制出口限制,是否可能让中国加速芯片开发的问题,基辛格坦言,芯片禁令如同一条魔术界线(magic line),限制太强确实促使中国打造自研芯片,的确伤害出口市场,因此要小心平衡,英特尔要确保这方面能符合全球生态系伙伴的期待。同时英特尔也会持续出口产品到中国,随着制程达到2nm以下,在中国半导体技术发展受到限制的背景下,英特尔这部分芯片在中国市场将更具吸引力。

编辑:芯智讯-浪客剑