6月11日消息,据Hpcwire援引半导体研究机构TechInsights最新公布的数据显示,2023年全球数据中心GPU总出货量达到了385万颗,相比2022年的267万颗增长了44.2%。其中,英伟达以98%的市场份额稳居第一。

英伟达2023年出货376万颗数据中心GPU

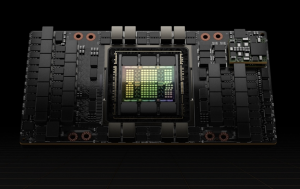

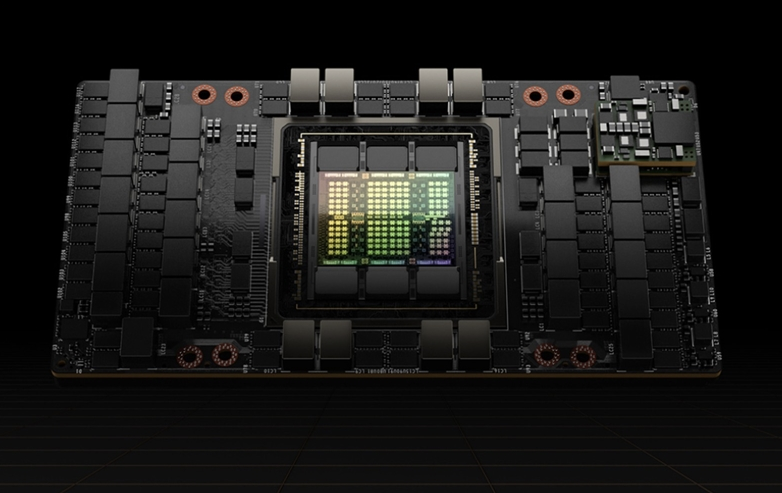

英伟达(Nvidia)的数据中心GPU(包括了面向AI的GPU)出货量达到了376万颗,相比2022年的264万颗增长了112万颗,在2023年全球385万颗数据中心GPU出货量当中,拿下了高达98%的市场份额,与 2022 年的市场份额相近。

也就是说,在数据中心GPU市场,AMD和英特尔(主要是数据中心GPU Max系列,未包括 Gaudi ASIC芯片)两家厂商加起来在2023年的总出货量只有9万颗。

如果按数据中心GPU销售收入来看,2023年英伟达也同样占据了整个市场98%的份额,达到了362亿美元,是2022年的109亿美元的三倍多。

值得一提的是,据市场研究机构Jon Peddie Research的最新报告显示,2024年一季度的全球独立显卡(AIB)出货量同比增长39.2%至870万张,英伟达也以高达88%的市场份额稳居第一。

显然,不仅在面向AI和HPC应用的数据中心GPU市场,英伟达具有着垄断性的领先优势,在消费类GPU市场英伟达也同样居于垄断地位。

来自英特尔、AMD、谷歌的竞争

TechInsights 分析师詹姆斯桑德斯 (James Sanders) 表示:“人工智能硬件还不足以匹配人工智能软件的快速进步。因此,英伟达GPU将会面临更多的竞争对手,比如谷歌的TPU、AMD的GPU、英特尔的AI芯片和GPU。”

桑德斯进一步指出:“我怀疑,由于人工智能的发展,它必须从英伟达对于市场的垄断,走向多元化,这是不可避免的。”

英伟达GPU的短缺和高昂的成本,帮助了 AMD 和英特尔等竞争对手,这两家公司在 2023 年凭借自己新的数据中心GPU,显示出了快速增长的迹象。

TechInsights 的数据显示,2023 年 AMD 的AI芯片出货量约为 50万颗,而英特尔则以 40万颗的出货量填补了剩余的空白。

目前,AMD 的 MI300 系列 GPU 市场表现良好,已锁定微软、Meta 和 Oracle 的采购订单。在 今年4月份的财报电话会议上,AMD 首席执行官 Lisa Su 表示,MI300 的销售额在不到两个季度内就达到了 10 亿美元。

在财报电话会议上,AMD CEO苏姿丰还表示:“我们现在预计数据中心 GPU 收入将在 2024 年超过 40 亿美元,高于我们 1 月份预计的 35 亿美元。”

在本月的Computex 2024展会上,AMD 还表示将每年发布新款 GPU,其中计划今年发布 MI325X,2025 年发布 MI350,2026 年发布 MI400。

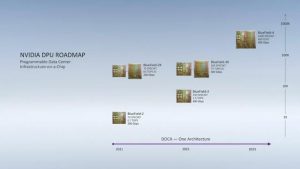

显然,AMD 正在跟随英伟达每年推出一款数据中心GPU的蓝图。英伟达在Computex 2024展会也宣布Blackwell芯片现已开始投产,2025年将会推出Blackwell Ultra GPU芯片。下一代AI平台名为“Rubin”,将集成HBM4内存,将于2026年发布。

英特尔目前则专注于 Gaudi AI 芯片,其最新推出的Gaudi 3 芯片性能和能效均优于英伟达H100,但是其价格仅为H100 的一半:对于那些不想为每张 H100 卡花费超过 30,000 美元的公司来说,这是一个诱人的价格。但这种芯片不像 GPU 那样灵活通用。生成式 AI 模型必须经过特殊编程才能在英特尔 Gaudi 芯片上运行,这需要付出很多努力。

相比之下,英伟达和AMD的GPU 更为通用,可以适合运行各种模型,英伟达的GPU有CUDA加持,更具优势。因此,英特尔也在开发下一代的面向AI和HPC的代号为“Falcon Shores”的数据中心GPU。不过,有消息称原来的Falcon Shores GPU遇到了问题,现在正在重新设计,计划于2025年发布。

英特尔首席执行官帕特·基辛格 (Pat Gelsinger) 在 4 月份的财报电话会议上表示,Falcon Shores “将 Gaudi 3 的出色收缩性能与完全可编程的架构相结合……随后我们将积极推出 Falcon Shores 产品” 。

基辛格还表示,Gaudi 3 让英特尔在 AI 芯片市场站稳了脚跟,英特尔目前预计“2024 年下半年的AI加速芯片收入将超过 5 亿美元”。

TechInsights 的桑德斯表示,考虑到英伟达GPU的供应和价格问题,其他的AI芯片厂商有着很多的机会,尤其是谷歌的 TPU。

桑德斯表示:“谷歌定制的TPU芯片相比亚马逊AWS、AMD、Ampere 等厂商的定制AI芯片工作产生的收入更高。”

谷歌于 2013 年就开始自主研发云端AI加速芯片,以满足加速内部工作负载的需求,距今已有近 10 年历史。在2015年推出自研的TPU以来,谷歌一直推动其 Google Cloud 数据中心采用自研TPU,目前已经发展到了名为 Trillium 的第六代TPU。与 TPU v5e 相比,Trillium的每芯片峰值性能高出 4.7 倍,HBM 内存容量和 HBM 内存带宽也高出两倍,能效提升了67%。同时谷歌还新发布了自研的基于Arm架构的数据中心处理器Axion CPU ,计划于今年晚些时候上市。

桑德斯说:“由于某种奇怪的市场力量融合,谷歌最终成为了第三大数据中心芯片提供商(按收入计算),仅次于英伟达和英特尔。”

TechInsights数据显示,自2015年推出自研的TPU以来,尽管谷歌没有对外出售自研的TPU,但其2023年自用的TPU芯片量已经突破了200万颗大关。就出货量来看,谷歌已经成为了仅次于英伟达的全球第二大数据中心AI加速芯片供应商。

除了TPU之外,“Argos 是谷歌为 YouTube 开发的视频编码器,考虑到 YouTube 每小时需要处理的所有视频。谷歌部署的每个定制的 Argos 视频编码器芯片,相当于取代了 10 个英特尔Xeon CPU。从功耗的角度来看,这也是一个巨大的变化。”桑德斯说。

云服务厂商自研芯片已成大势所趋

对于头部的云服务厂商来说,面对自身对于数据中心CPU和AI加速芯片的庞大需求,以及自身特定的软件堆栈及应用需求,自研定制芯片不仅能够提供更高的能效表现,也能够降低芯片外采成本和能耗成本,还能降低对于少数芯片供应商的依赖。

因此,我们可以看到,谷歌、亚马逊、阿里巴巴、华为、百度、微软等众多的云服务厂商近年来都有推出自研的数据中心CPU和AI加速芯片。

除了前面提到的谷歌面向数据中心的Axion CPU 和 TPU之外,亚马逊也拥有自己的面向数据中心的 Graviton CPU 和名为 Trainium 和 Inferentia 的云端 AI芯片,它正尽可能地为客户降低使用各种云端算力和服务的成本。

TechInsights在研究报告中称,2023年,AWS向客户出租了相当于230万颗数据中心处理器,其中Graviton占比17%,超过了该平台上AMD芯片的使用量。“即使销量很高,他们的总收入也不会很高。他们希望保持……与英特尔或 AMD 驱动的实例相比,拥有 10% 到 20% 的折扣。”桑德斯说。

阿里巴巴很早也推出了自研的数据中心AI加速芯片含光800,随后又推出了自研的Arm架构的数据中心CPU——倚天710。目前这些自研芯片主要都被用于阿里巴巴内部的服务以及云服务的相关实例当中。

此外,华为也有自己的Arm架构的数据中心CPU鲲鹏920系列,以及数据中心AI加速芯片昇腾910系列等。百度也很早有推出自己的数据中心AI加速芯片昆仑芯,该业务已经分拆独立,并对外供应。

微软也推出了自己的数据中心处理器Cobalt 100和数据中心AI加速器 Maia 100。虽然微软的 AI 基础设施目前仍依赖于英特尔CPU和英伟达GPU,但目前微软已经开始逐步将其软件堆栈调整为自研芯片。

目前,所有主要的云提供商和超大规模提供商都在开发自研的数据中心处理器,以取代英特尔和 AMD 生产的芯片。但是目前英特尔和AMD在数据中心CPU市场仍占据主导地位,而英伟达则在数据中心GPU领域的占据绝对垄断地位,并迫使云提供商分配由英伟达控制的专用空间,而英伟达将其 DGX 服务器和 CUDA 软件堆栈放置在这些空间中。

桑德斯表示:“头部的云服务大厂不会完全摆脱英特尔、AMD 英伟达,因为客户对于云平台中基于这些芯片支持的实例的需求永远存在。”

编辑:芯智讯-浪客剑